机器学习(6)——性能度量

0x00 性能度量

对学习器泛化性能进行评估时,不仅需要有效可行的实验估计方法,还需要有衡量模型泛化能力的评价标准,这就是性能度量。

性能度量反映任务需求,在对比不同模型的能力时,使用不同的性能度量往往会导致不同的评判结果,也就是说,模型的好坏是相对的,需要根据实际情况进行选择。

0x01 回归任务中的性能度量

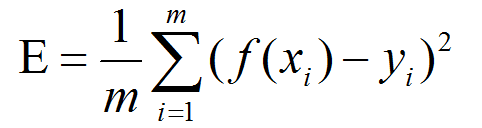

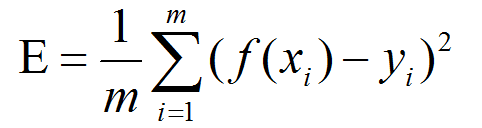

回归任务中最常用的性能度量是“均方误差”(mean squared error)

对于一般的数据分布D和概率密度函数p,均方误差可以表示为:

0x02 分类任务中的性能度量

错误率与精度

分类任务中最常用的两种性能度量就是错误率和精度,同时适用于二分类和多分类任务。

错误率是分类错误的样本数占样本总数的比例。

精度是分类正确的样本数占样本总数的比例。

对于一般的数据分布D和概率密度函数p,错误率和精度可以表示为:

查准率、查全率与F1

错误率和精度只能表示一部分的性能,如果我们要深入的研究这个问题,就需要用到别的性能度量。

查准率P是我们检索到的样本中有多少比例是正确的。

查全率R是正确的样本中有多少被检索到了。

| 真实情况\预测结果 | 正例 | 反例 |

|---|---|---|

| 正例 | TP(真正例) | FN(假反例) |

| 反例 | FP(假正例) | TN(真反例) |

从定义我们就可以得出,差准率和查拳率是一堆矛盾的变量。一般情况下,查准率高时查全率就会低;查全率高时查准率就会低。

如果我们我们根据学习器的预测结果对样例排序,最可能正确的排在最前,最可能错误的排在最后。按照这个顺序逐个把样本作为正确的进行预测,则每次可以计算出当前查全率、查准率。

然后以查准率为纵轴,查全率为横轴作图,就得到了查准率-查全率曲线,也称为“P-R”曲线。

如图:

P-R图可以直观的表示学习器在总样本上的查全率和查准率,如果一个学习器的P-R曲线被另一个学习器的P-R曲线完全包住,则可以断言后者的性能优于前者。如果P-R曲线交叉,则需要根据实际的需求来进行比较。如果一定要把学习器的性能分个高低,一个比较合理的判据是比较P-R曲线下面积的大小,它在一定程度上表征了学习器在查准率和查全率上取得相对“双高”的比例。

这个面积值不容易估算,所以又设计了一些综合考虑查准率和查全率的性能度量。平衡点(Break-Event Point)就是这样一个度量,它是“查准率=查全率”时的取值,可以通过比较BEP值来比较学习器的性能。

但是BEP过于简化,我们更常用的的是F1度量:

其中TP是假设正确并且实际正确的样例数,TN是假设错误并且实际错误的样例数。

在实际的应用中,我们要根据不同需求改变对查准率和查全率的重视程度。如商品推荐中应该尽可能推荐用户最感兴趣的,查准率更重要;在逃犯信息检索中,需要尽可能不漏掉逃犯,所以查全率更重要。所以就引出了F1度量的一般形势Fβ,能表达出对查准率和查全率的不同偏好。

其中β代表查全率与查准率的相对重要性,在β=1时,就是F1;在β>1时,查全率更重要;在β<1时,查准率更重要。

ROC与AUC

在分类时,我们会选择一个阈值判别,我们将学习器的预测结果对样例排序,最可能正确的排在最前,最可能错误的排在最后。然后我们可以通过一个截断点来把样本分成两部分。在不同的任务中,我们可以根据实际的需求选择不同位置的截断点,如果我们更重视“查准率”,则可以选择排序中靠前的位置进行截断;若更重视“查全率”,则可选择靠后的位置进行截断。

ROC全称是“受试者工作特征”曲线,我们根据学习器的预测结果对样例进行排序,按此顺序逐个把样本作为正例进行预测,每次计算出两个重要量的值,分别以它们为横纵坐标做图,就得到了ROC曲线。与P-R曲线使用查准率、查全率为横、纵轴不同,ROC曲线纵轴是“真正例率”(TPR),横轴是“假正例率”(FPR)。

进行学习器比较时,若一个学习器的ROC曲线被另一个学习器的ROC曲线完全包裹,那么可以断言后者性能优于前者,若两个学习器发生交叉,则比较ROC曲线下的面积,即AUC(Area Under ROC Curve)

代价敏感错误率与代价曲线

在现实情况中,分类错误之后不同类型错误所造成的后果也不同,比如安检通道把钥匙等金属制品错误的分类到危险品,仅仅是多了一层人工检查的麻烦;但是如果把一把刀错误的分类到安全品里面,那么可能造成十分严重的后果。不同的错误造成的损失是不同的,为了权衡这个损失,可以为错误赋予“非均等代价”(unequal cost)。

我们可以用一张表来代表代价:

| 真实类别\预测类别 | 第0类 | 第1类 |

|---|---|---|

| 第0类 | 0 | cost01 |

| 第1类 | cost10 | 0 |

如果是多分类问题,costij代表第i类的错误被归到第j类所引起的代价。

我们前面的几种方法都是以最小化错误次数为目标的,也就是认为所有错误的代价是均等的。

在非均等代价下,就需要代价曲线来表示学习器的总体代价。代价曲线图的横轴取值为[0,1]的正例概率代价:

代价曲线的绘制则是ROC上每一点对应了代价平面上的一条线段,设ROC曲线上点的坐标是(TPR,FPR),则可以计算出FNR,然后在代价平面上绘制一条从(0,FPR)到(1,FNR)的线段,线段下的面积即表示了该条件下的期望总体代价。

然后将ROC曲线上的每个点都这样转换成一条线段,再取所有线段的下界,围成的面积即为在所有条件下学习器的期望总体代价。如图:

0x03 参考文档

《机器学习》——周志华

本博客所有文章除特别声明外,均采用 CC BY-SA 4.0 协议 ,转载请注明出处!